「よい行動」

- 状態

- こたえ: 一連の行動がおわったときの

- たとえばある状態

- たとえばある状態

- あくまで主観

- ひとそれぞれ。何をやってもいつか死ぬので難しい話

- 問題: これからの人生をモデル化してみましょう!

- 趣味に生きるか、スキルをつけるか、人のために生きるか、タバコを吸うか、酒を飲むか、あるいはその全部か・・・

補足

- 数値ひとつで行動が決められるのか?

- 行動は同時にできず1つしか選べない

- 選んだ行動がなんらかの点数付けの上で一番良いから選ばれていると解釈することは可能

- 行動は同時にできず1つしか選べない

- 行動決定問題の面白さ

- 「損して得とれ」という構造がよく出現する

- その場で一番良い行動が将来的に一番良い行動とはならないので難しい

- 依存症は一種の「バグ」

- その場で一番良い行動が将来的に一番良い行動とはならないので難しい

- 「損して得とれ」という構造がよく出現する

- 行動決定問題を解く鍵

- 「今は損な行動でも、将来的には良い」という確証をどう計算で得るか?

- なにかの将来的な期待値を計算することに

- 「今は損な行動でも、将来的には良い」という確証をどう計算で得るか?

強化学習

- 評価がよりよくなる行動をロボット(エージェント)に選ばせるように学習させる仕組み

- 学習するもの:

- ある状態

- ある状態

- 損失関数

簡単な例題で考えましょう

- タイルワールド(右図)のQ学習を扱う

- こんな問題

- ロボットは右か左どちらかを選択してサイコロを振って出たマスだけ移動

- 端より先には行けず、そこに停留

- ゴール or 穴のマスに止まれば終了

- ロボットは右か左どちらかを選択してサイコロを振って出たマスだけ移動

- 記号などの定義: 右図

- ある場所から出発したときに、損失の期待値を最小化したい(どうしましょう?)

一番よい方策(最適方策)

- おそらくこれ

(とにかく穴をさけたほうがよい)

- 最適方策:

右 左

- これをどうやってコンピュータに解かせましょう?

問題の性質

- ある状態に対し、そこからスタートしたときの損失関数の期待値が計算可能

- 損失関数:

- 右図: 計算したもの

- 損失関数:

- 別の状態からスタートしても、ある時点で

- 過去のことはこれからの行動選択には無関係

- 別の状態からスタートしても、ある時点で

- 損失関数の期待値を状態の関数にできる

- 終端状態の価値を拡張して

関数

- 終端状態の価値を拡張して

状態価値関数の性質

- 方策にしたがって行動をとったときに次の関係

(複数の候補あり)

- 右の例: 左端の2つの状態が分かりやすい

- 問題: 左から3つめの状態について計算を

- もし別の行動をとって右辺のほうが左辺よりよかったら

方策の改善

こういう方法が考えられる

- 最初に適当な

- 次の2つの値を比較

- 後者のほうがよければ

Q学習

- 先ほどの原理でロボットを

学習させてみましょう - ただし、行動価値関数というものを考える

状態

- まず、

値の更新

- ロボットに適当に動いてもらって

- 更新式

- もとの

- もとの

方策の工夫

- 方策が完全にランダムだとゴールに着かず

学習が進まない - そのときに一番良い行動しかとらないと

別の可能性が探れない- 例: 右図のようになってしまうと

- こういうことは日常でないだろうか?

- 例: 右図のようになってしまうと

(- 確率

- 確率

- 確率

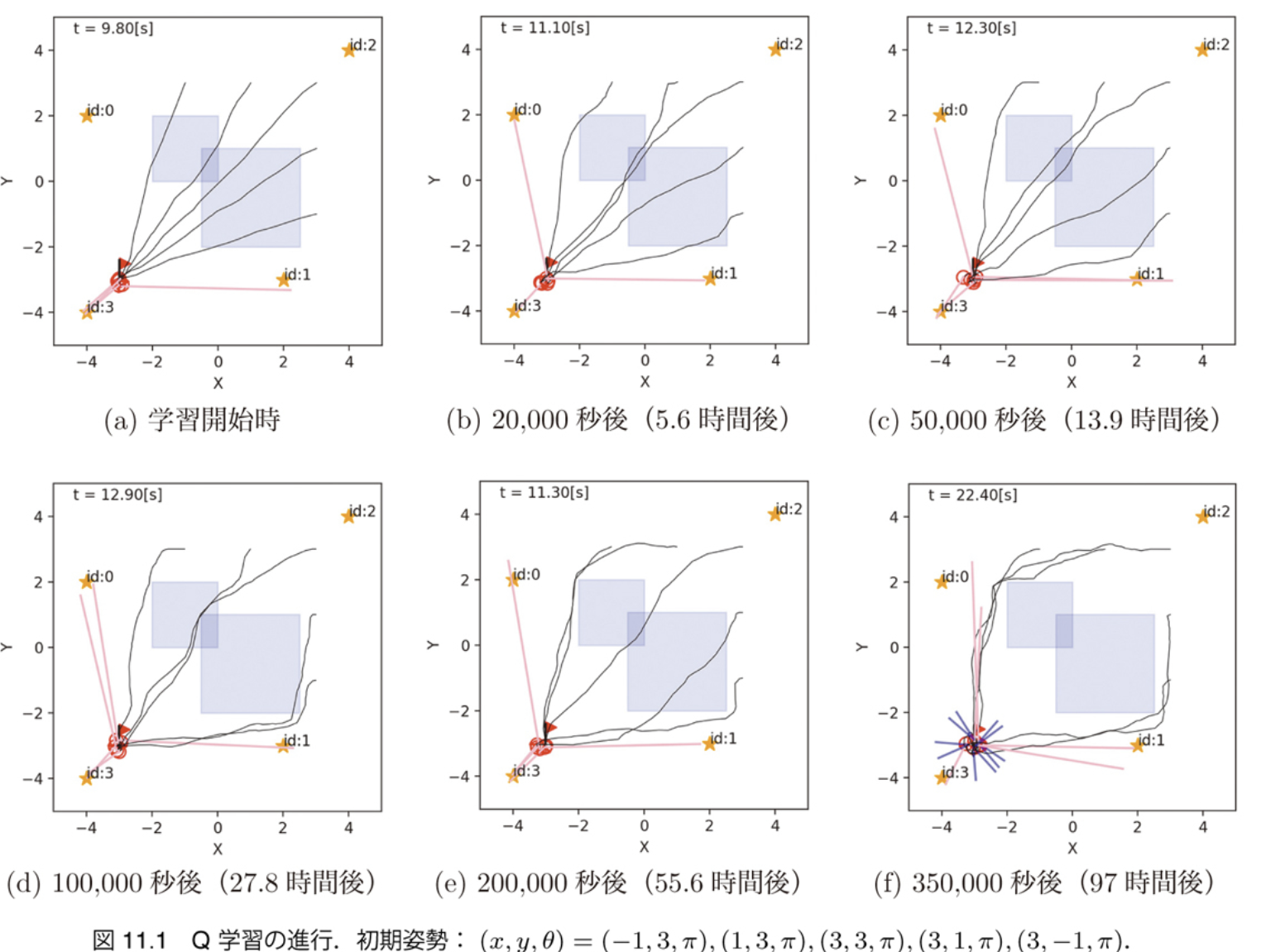

学習の実行例

- 100試行までには最適方策が得られている

少し大きな問題

- 右のロボットが、水たまりを避けてゴールに

行くように学習させたい- いまのところ水たまりに一直線

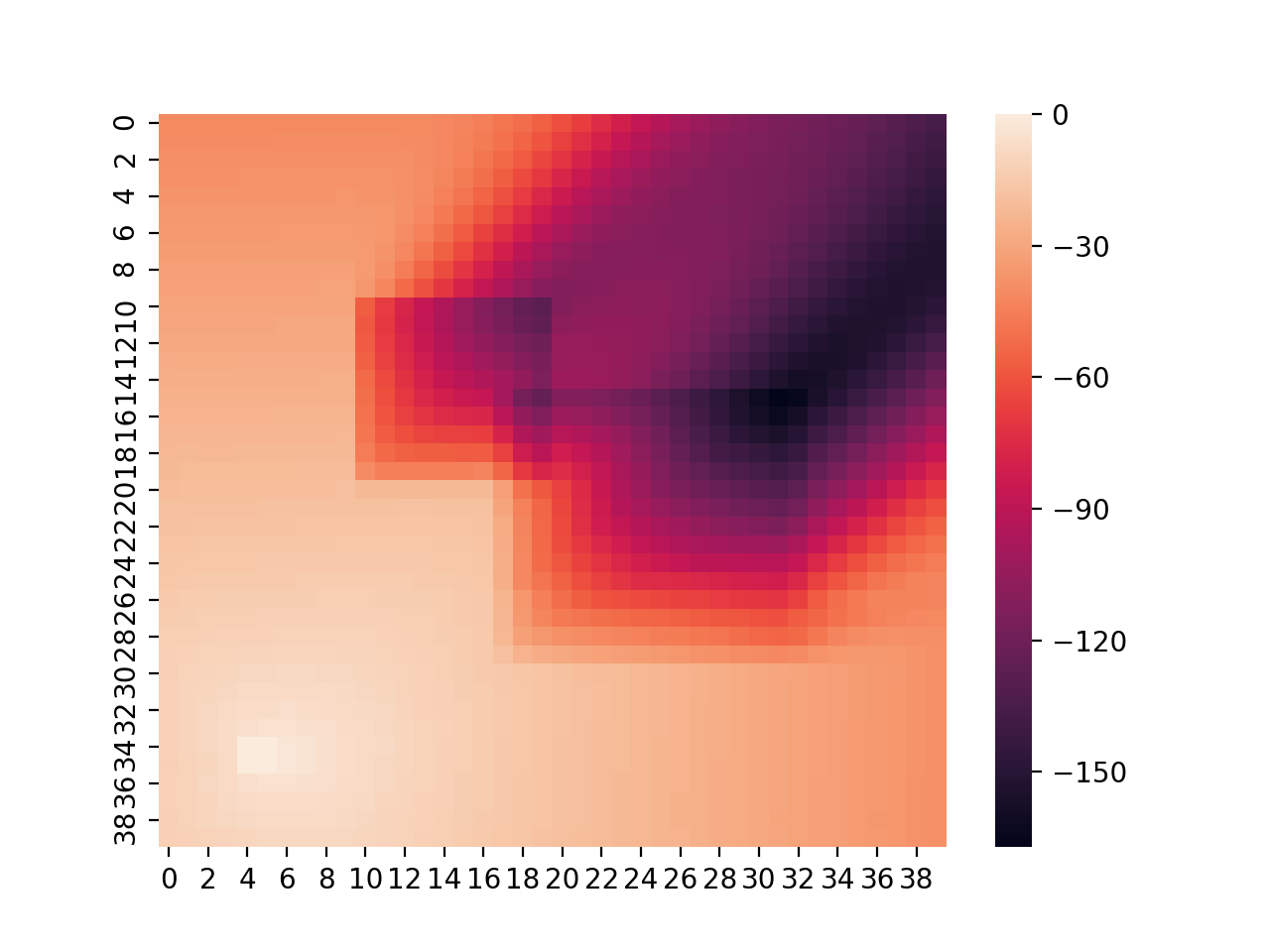

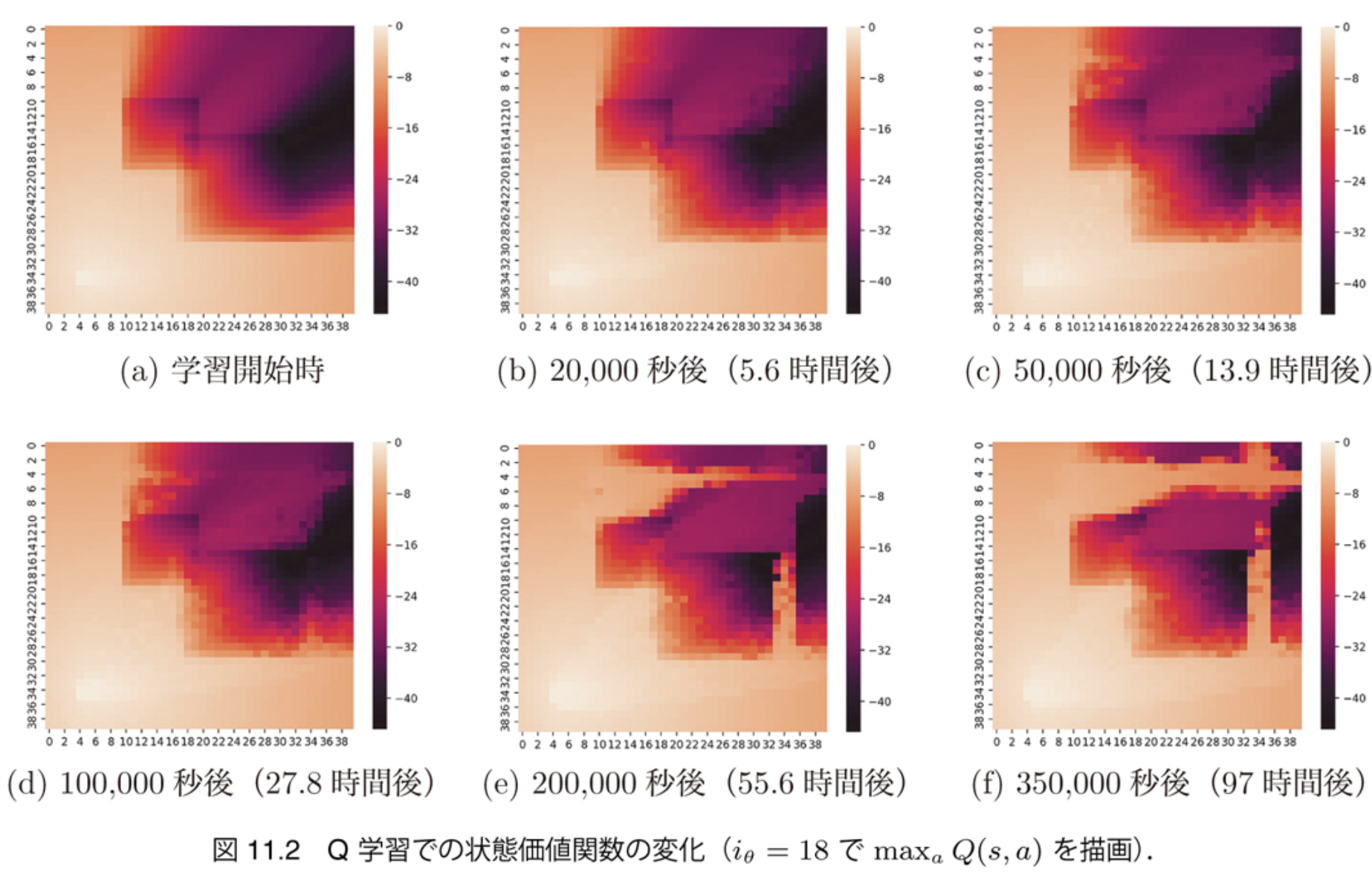

- 下図左: 方策(ロボットが左を向いている時のもの)

- 下図右: 状態価値関数(同上)

ロボットに行動させる

- 水たまりに入ると損失を与える

- Q学習の式で行動価値関数を書き換え

学習の進行: 行動の変化

- 時間はかかるがだんだん水たまりを避けるように

学習の進行: 状態価値関数の変化

- ゴールまでの損失が減っていく

もっと複雑な問題

- DQN (Deep Q-Network) [Mnih 2013]

- ゲームをするエージェントを実現して騒ぎに

- ゲームの学習方法

- 画像(全体の)をCNNに通して特徴で分類して状態に

まとめ

- 行動の評価方法(損失・価値)について

- そのときの行動に対する損失と、最終的な状態に与えられる価値がある

- 補足: 最終的な状態の価値の代わりにその直前の行動に対して与える場合もあるが等価

- そのときの行動に対する損失と、最終的な状態に与えられる価値がある

- 強化学習、その中のQ学習を見てきた

- 行動と状態、損失の観察(=経験)から状態の「価値」を計算