クラスタリングの古典的手法

- ロボット分野で30年前から利用されてきたもの

- k-means法

- EM法

- 解く問題

- 点が散らばっているときに、どれとどれが同じグループに属するか決める

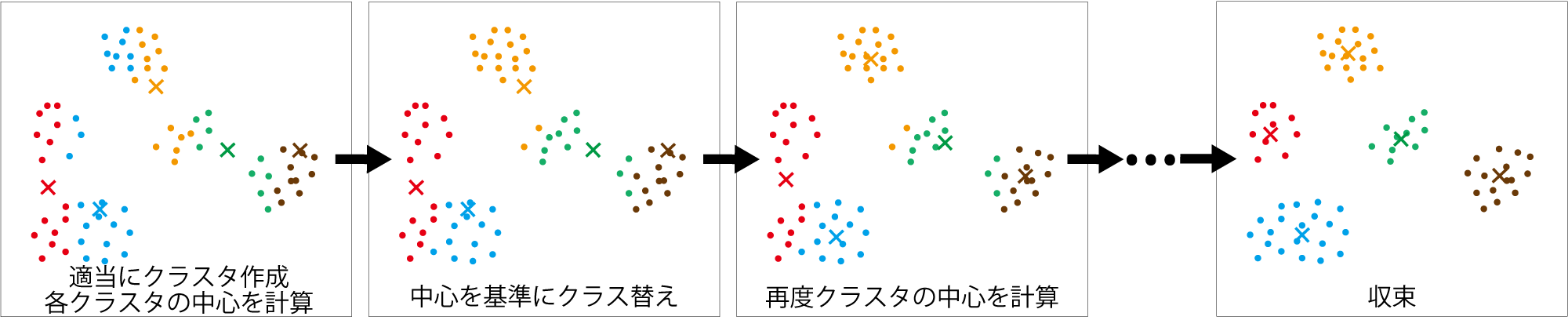

k-means法

- データを適当にクラスタに分けて、以下の繰り返しで収束させる

- 各クラスタの中心を求める(図中の

- 各データを最寄りの中心を基準に再度クラスタリング

- 各クラスタの中心を求める(図中の

数字をk-means法でクラスタリングしてみましょう

- 次の9個の数値を3つのクラスタに分けてみましょう

- (8, 1, 3), (5, 5, 2), (6, 11, 7)

- かっこは適当に分けた初期のクラス分けを表します

- 答えは次のページ

- (8, 1, 3), (5, 5, 2), (6, 11, 7)

- 注意

- 平均値が同じになったら所属クラスタは適当に選択のこと

- あるデータに対して近い平均値が2つ以上になったら(同じ距離になったら)

元いたクラスを替えてみる

こたえ

- 初期値: (8, 1, 3), (5, 5, 2), (6, 11, 7)

- 再配置: (1, 5, 2), (3, 5), (8, 6, 11, 7)

- 再配置: (1, 2, 3), (5, 5), (8, 6, 11, 7)

- 再配置: (1, 2, 3), (5, 5, 6), (8, 7, 11)

- 再配置: (1, 2, 3), (5, 5, 6, 7), (8, 11)

- 再配置: (1, 2, 3), (5, 5, 6, 7), (8, 11) (変わらず。終了)

k-means法の問題

- 最初からクラスタ数を決めていいのか?

- センサやロボットのプログラミングのときに特に困る

- たとえば画像に人が何人いるかが知りたい。最初から3人と分かることはあまりない。

- センサやロボットのプログラミングのときに特に困る

- クラスタがいびつだったら?

- これはいびつさを解消するようにデータを変換するか、別の方法を用いる(サポートベクターマシーンなど)

- もっと根本的な問題: データの発生した理由を考えていない(つまり場当たり的)

EM法(最尤法)

- EM: expectation maximization

(どういう意味かはあとで説明)

- ある確率分布のモデル(数式)を考え、データを

最ももっともらしく説明するパラメータを求める- なんで右図のようなデータが発生したのか?

そのまわりにデータが発生、と考える

- なんで右図のようなデータが発生したのか?

「データの発生源がいくつかあって

そのまわりにデータが発生」

この場合の基本的なモデル: 混合ガウス分布

- 複数のガウス分布を足して、

正規化(積分して1に)したもの

(注意: 円周率ではなく、混合比率)

- 絵に描くと右図のように

(ちょっと当てはまりは悪いです)

データに対する「一番尤もらしい分布」

- 次の尤度を最大化するものが「一番尤もらしい」と考える

- 左辺: データ

- 右辺: 各データ

- データは既知なので、最も尤もらしい(最尤な)パラメータ

- 左辺: データ

- 具体的に書くと

- 左辺

- 左辺

- 対数をとって掛け算を足し算にして、対数尤度を最大化する問題にする

- 問題が等価で簡単なものに

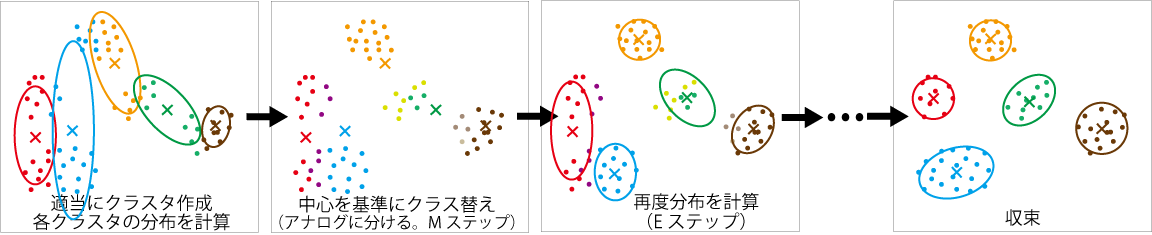

対数尤度が最大になるパラメータの求め方(k-means法と似ている)

- 最初に適当にクラスタリング

- Mステップ(maximization step)

- 尤度が最大となる各クラスタの

- 尤度が最大となる各クラスタの

- Eステップ(expectation step)

- その時点での各データのクラスタへの所属の確率を計算

Eステップ

- 各データ

- 混合ガウス分布のパラメータ

- k-meansと違って、1つのクラスタへの所属に断定しない

- 分からないのだから曖昧にしておく

- 混合ガウス分布のパラメータ

- 数学的には

- 計算式の導出

Mステップ

- 方法(

- 補助のパラメータ

- 各クラスタの要素の個数に相当

- 各クラスタの大きさと、平均値、共分散行列を

- 補助のパラメータ

EM法で可能となること/ならないこと

- 可能になること

- 確率的な考え方の導入

- (実例がなくて申し訳ないのですが)性能はk-meansより上がる

- はっきりしないことは曖昧なままにしたほうが変な間違いが少ない

- 「確率モデルに対して最尤」という基準ができる

- 他の確率モデルにも適用できる

- (実例がなくて申し訳ないのですが)性能はk-meansより上がる

- 確率的な考え方の導入

- 可能にならないこと

- もっと確率的であってもよい

- パラメータにも分布がある(混合ガウス分布も確率的にばらつく)

- ガウス分布の個数が決まっている

- 不要な個数の分布が消えるほどの性能はない

- もっと確率的であってもよい

変分推論

第5回のおさらい

- 実験の成功、失敗の結果から、「成功率の分布」を考えた

- ベータ分布:

- 実験の結果を1つずつ反映していくと、成功率の分布が変化していった

- 下図: 成功、成功、失敗、失敗の場合の分布の推移

- 成功率1/2と決めつけない

- 下図: 成功、成功、失敗、失敗の場合の分布の推移

- 分布の変化はベイズの定理で計算できた

- ベータ分布:

混合ガウス分布のベイズ推定

- 「混合分布の分布」を考える

- 右図のように分布をドローできるもの

- EM法との違い

- 最尤なものでなく、分布の分布自体を計算

- データが入ると分布をベイズの定理で更新

- 問題: 事後確率がベイズの定理一発で計算できない

- どうするか?

- どうするか?

推定対象(混合ガウス分布)のパラメータ

「分布の分布」ではなく「分布」のほうの話

- 各ガウス分布のパラメータ:

- (おさらい)混合ガウス分布:

(

- (おさらい)混合ガウス分布:

- 各データ

- どのガウス分布に所属しているか

- 潜在変数

変分推論による解法

- 推定対象の分布を、パラメータごとに独立な分布の積にして近似

EM法と同じ(だけど計算はよりややこしく)

- 次ページから

(

(添字- これは特定の式にせずにテーブル状のデータに

- 各データに対する

- ディリクレ分布を仮定

- ベータ分布をコインの裏表だけでなく多変数に拡張したもの

- 例: さいころなら6

パラメータ

- ベータ分布をコインの裏表だけでなく多変数に拡張したもの

- 各ガウス分布

ガウス-ウィシャート分布- ウィシャート分布

- 各ガウス分布の分布を決めるパラメータ:

- ウィシャート分布

- 各ガウス分布ごとの

これまでの変数、パラメータ一覧表

| データ | 推定したい分布のパラメータ | 推定したい分布の分布のパラメータ |

|---|---|---|

変分推論の手続き

- 適当に

- 確率

- パラメータ

- 確率

- EM法のMステップに相当(変分Mステップ)

- EM法のEステップに相当(変分Eステップ)

- 注意:

- 事前分布を固定して、繰り返し事後分布の解を良くしていく

変分推論の威力(その1)

とても強力なので具体的な計算方法の前に例を見せます

- 例1: 2次元の点のクラスタリング

- 右図: 6個のガウス分布を含む混合ガウス分布からランダムに選んだ点

- このデータのクラスタリング(というより発生した混合ガウス分布の推論)に変分推論を適用するとどうなるか

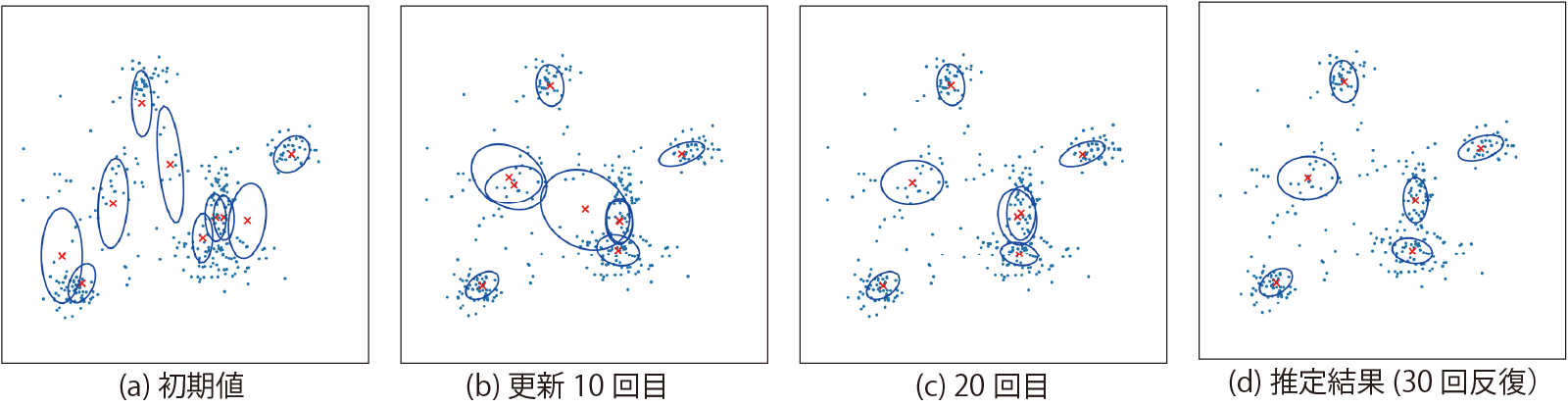

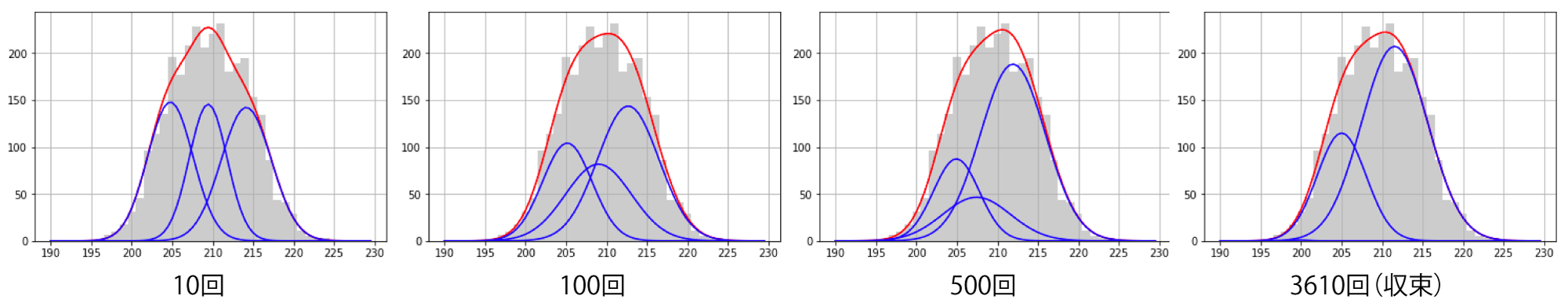

推論の推移

- 混合ガウス分布の分布から平均値となる分布を描画

- 10の分布があることを仮定

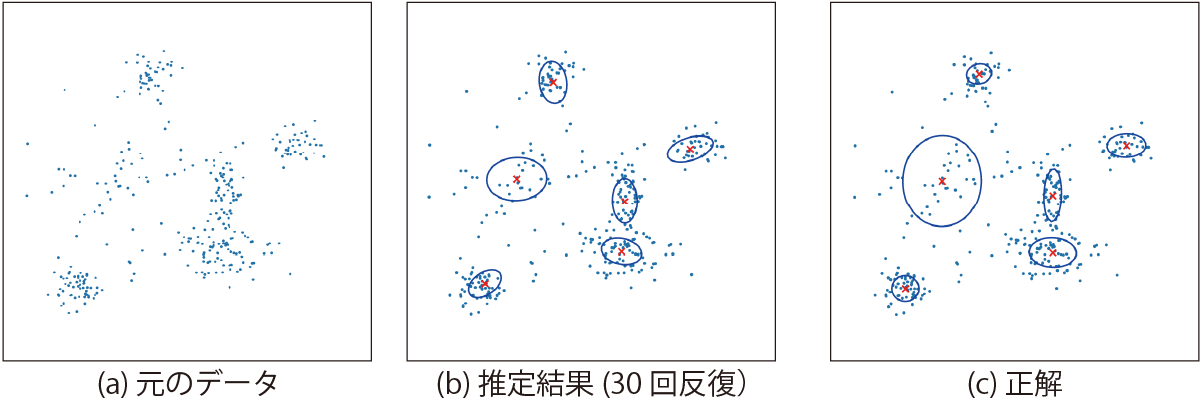

正解との比較

- 共分散行列のずれは多少あるが、正確

- 人間より正確かもしれない

- (上限があるものの)数が数えられるのはかなり有用

変分推論の威力(その2)

- 例2: 1次元のデータの解析

- 講師が本を書いていて偶然発見

- 右の分布はガウス分布か?

変分推論してみると・・・

- もうひとつの分布が埋まっていた

- このデータは、あるセンサの値を3秒ごとにとったもので、日が出ているときと出ていないときで平均値が違っていた

- ある意味、人間よりもクラスタリングの解像度が高い

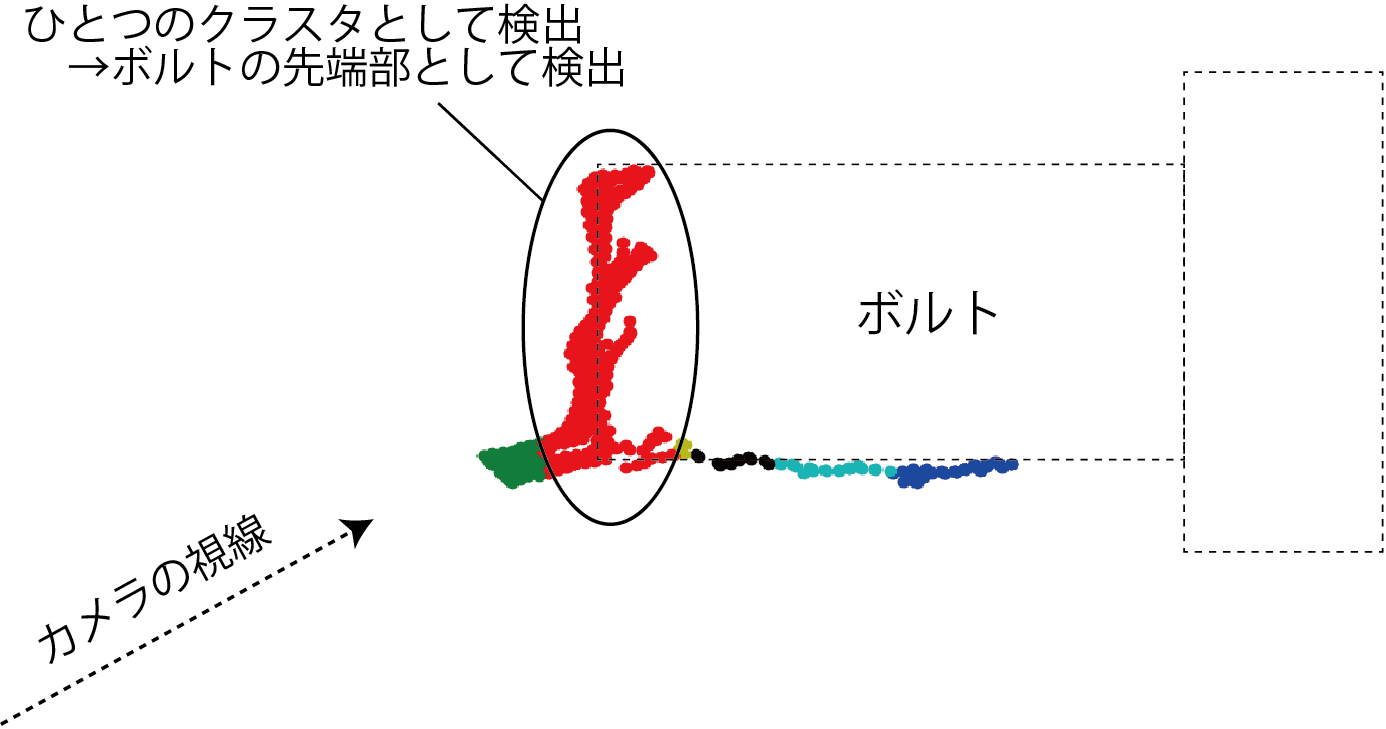

実世界での使用例1

- ボルトの先端の検出

- 3次元の位置を1次元に変換してからクラスタリング

実世界での使用例2

- 物体表面の把持位置の

クラスタリング- 法線ベクトルの位置、向きの6次元空間

変分推論の具体的な計算

- 導出は難しすぎるので(教科書に解説あり)、

MステップとEステップでの作業だけ示します- 導出された式に当てはめるだけで使用可能

変分Mステップ(各データの所属から分布のパラメータを計算)

- 補助の数値を計算

- 事後分布のパラメータを計算

(各ガウス分布の共分散行列の調整)

変分Eステップ(分布のパラメータから各データの所属を計算)

- 計算結果: 次の

- 式中の変数はすべて一時的に値が決まっているか既知なので計算可能

まとめ

- k-means、EM法をまず勉強

- 確率的な考えのないものと、ベイズ未満の確率的なもの

- 変分推論(変分ベイズ)

- 混合分布の分布を考える

- EM法とおなじく繰り返しでクラスタを形成していく

- 計算方法が(扱わなかったけど)ベイズの定理に基づいている

- 強力

補足資料

EM法の一般的な導出

- p.13の対数尤度、p.14の潜在変数を次のように記述(記号を減らすため)

- 対数尤度を右辺に移動し、各項に

- 左辺の積分は

潜在変数を考慮してEM法を導出(続き)

- 右辺に足して0になる2項を増やして配分

- 新たな関数を定義して整理

できた式

- 分布

(一致すると

- 分布

- 対数尤度(左辺はこれより値が下にならない。KLが0以上なので)

できた式と使い方

- 分布

(一致すると

- 分布

- 対数尤度(左辺はこれより値が下にならない。KLが0以上なので)

- 使い方