回帰問題の解き方

- 最小二乗法から人工ニューラルネットワーク(ANN)まで様々

- とりあえず基本の最小二乗法から見ていきましょう

- 話の流れ: 最小二乗法は確率的ではないので限界がある

- 話の流れ: 最小二乗法は確率的ではないので限界がある

最小二乗法

- 横軸の値(

- 例(日本病院薬剤師会のデータ)

- 知りたいこと

- 身長に対して体重はどんな法則性があるか?

- 血圧に対して中性脂肪の濃度はどんな法則性があるか?

- 縦の分布が大きいが、とりあえず中心となる法則性を見つけたい

(例として出しただけで解きませんが)

- 知りたいこと

- 例(日本病院薬剤師会のデータ)

回帰を使う場面

右のデータなら確率分布を当てはめてもよさそう

- 横軸の分布を考える意味がない/興味がない

- 意味がない場合: 時系列データなど

(例: 株価、人口の推移)- 時間を分布で扱う必要はない

- 意味がない場合: 時系列データなど

最小二乗法による一次方程式のあてはめ

- 点

- おそらくどこかで勉強した、一番基本的な回帰

どうやって「真ん中」を決めるか

- 線とそれぞれの点の

- 損失関数

- なんで2乗?: 必然性はないが分散を最小にしたいと解釈すれば自然

- 損失関数

- 損失関数はANNでも重要

- やっていることはあまり変わらない

損失関数を最小化するパラメータの導出

- 損失関数をパラメータで偏微分して、

- 前ページの式を解いてみましょう

答え

- 問題が数式の変形で解けてしまうのでANNを使う必要がない

計算してみましょう

- 式(さっき求めたもの):

答え

- 各種平均値を計算

- 各種平均値を計算

(偏)微分方程式で解けない場合の最適化

- どうやって

- どうやって

- ためしに

- 後者の値が小さくなったら

「よりよく」なる

- 後者の値が小さくなったら

- 問題: いろいろ

ふたたび偏微分

は、- 変化量の計算

- わかること

- 上記の赤字の式にしたがってパラメータを更新すればよい

- これがANNのやっていること

最小二乗法と損失関数に関するまとめ

- 損失関数を偏微分して連立方程式を解ければ、任意の式に最小二乗法(と、その他さまざまな最適化手法)を適用可能

- 連立方程式が解けない場合は勾配ベクトルにしたがって少しずつパラメータを変更していけば良いパラメータが見つかる

- 具体例はアドバンストビジョンに

- しかし、なにか足りないんじゃないでしょうか?

- 前回(ベイズの定理)の話を踏まえるとなにか抜けてないか?

残った問題

- 最小二乗法は1つの答えしか出さない

- 「自信のなさ」が表現できない

- データ4つで右上図のように当てはめしてよい?

- パラメータの数が多いと「過学習」

- データを曲線でつないだグラフができる

- 人間でもよくある

- データを曲線でつないだグラフができる

ベイズ線形回帰

- 関数の分布ってなに?

- 関数の分布ってなに?

- 例:

- 右図:

- どちらも平均値

- データ(丸印)に合うように、ベイズの定理で

- どちらも平均値

ベイズ線形回帰のための数式

ややこしいので意味だけ考えましょう

- 例: 当てはめる式: 多項式

- いくつか仮定を置きましょう

- 仮定1:

- 仮定1:

回帰のための数式(続き)

- 仮定2:

- 分布

- 分布

回帰のための数式(続き)

- 仮定3:

- こういう分布:

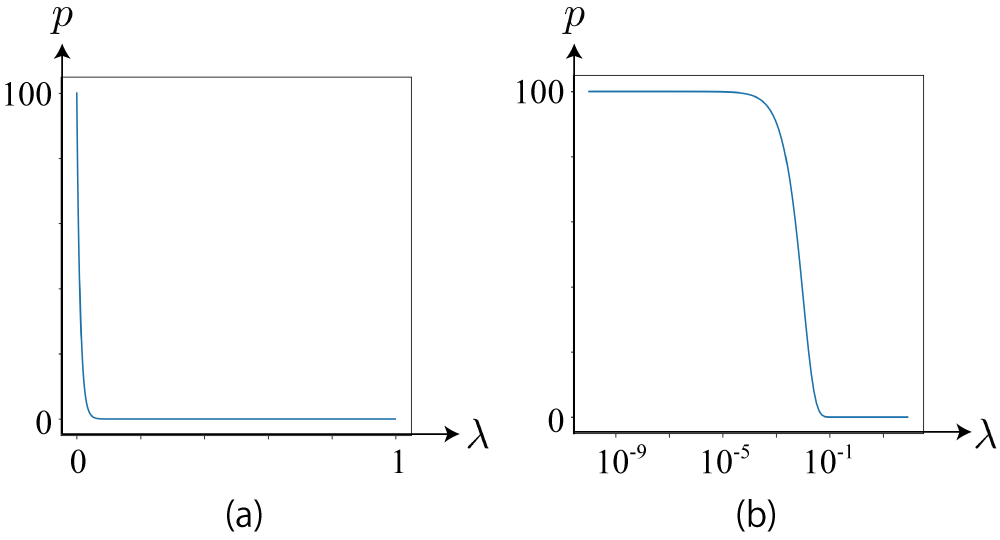

- 下図(a): ガンマ分布の確率分布

- 下図(b): (a)の横軸をlog尺にしたもの

- こういう分布:

回帰の方法

(=事前分布のパラメータ)

- 「ガウス-ガンマ分布」と呼ばれる分布

回帰の方法(続き)

- データ

- ベイズの定理を使う

- ベイズの定理を使う

回帰の方法(続き)

- 左辺の事後分布が同じ形だとすると、こういう等式ができる

- ガウス分布の積が第4回で出てきた式:

- ガウス分布の積が第4回で出てきた式:

回帰の方法(計算結果)

- 左辺はガウス-ガンマ分布となり、事後分布のパラメータはこうなる

ポイント

- 事前確率と事後確率の分布が同じ形

- 事前確率:

- 事後確率:

- 事前確率:

- 講義だとどうしても原理の話になり、それは重要なのだけど、使うときは前ページの下の4つの式に事前分布のパラメータとデータの値を入力するだけ

- まず大事なことは、使いどころがどこなのかおさえておくこと

データが複数の場合

- 最小二乗法のように一気に計算可能

- データ

- ここで

- ここで

さらに

- いろんな関数に係数をかけて足したもの

- 実は前ページの式がそのまま使える

例:

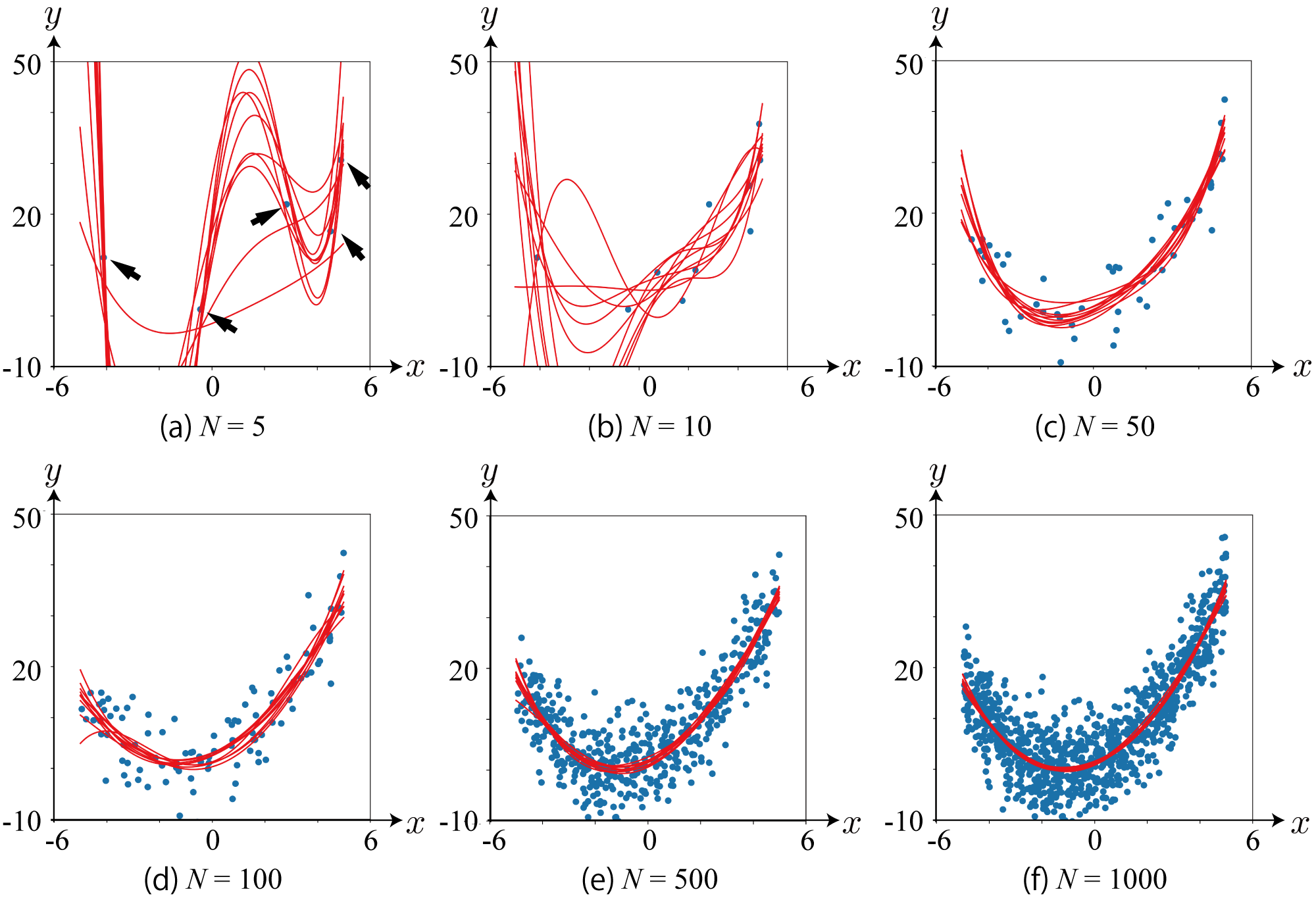

- 少しずつデータを入力して、事後分布から関数(多項式)をサンプリング

- データが増えるにしたがって関数のばらつきが減る

- データ(2次関数からサンプリング)にしたがい、高次のパラメータが

まとめ

- ベイズの定理で回帰がより一般的に

- 関数の分布=パラメータの分布と考える

- データの不足によるあいまいさをも考慮可能に

- ベイズ線形回帰の導出

- 難しいが結果は機械的に使用可能

- 使いどころを間違えなければ誰にでも便利な道具に