埋め込みの方法(例: skip-gram)

- word2vecというモデル群のなかのひとつ

- 右図のような人工ニューラルネットワーク

- ある単語

- ある単語

- 入力:

- ある単語について、その単語に対応する要素が

- 単語の種類だけ次元がある

- ある単語について、その単語に対応する要素が

- 出力:

skip-gramで埋め込みを作る

- 学習: 大量の文章から

- 学習済み行列

- ある単語

埋め込みができればコンピュータが文章を認識する?

・・・ことはできない

- 最尤な単語をskip-gramで予想して並べていけばそれっぽい文は作れるけど、たぶん無意味な文ができる

- マルコフ連鎖ジェネレータのようなもの

- 単純な埋め込みには限界

- 語順に関する情報は、完全にはない

- 文脈依存な情報を持っていない

- 同音異義語に1つのベクトル

- 例: チンチラ(げっ歯類にも猫にもいる)

- 同音異義語に1つのベクトル

どうすればいいか?

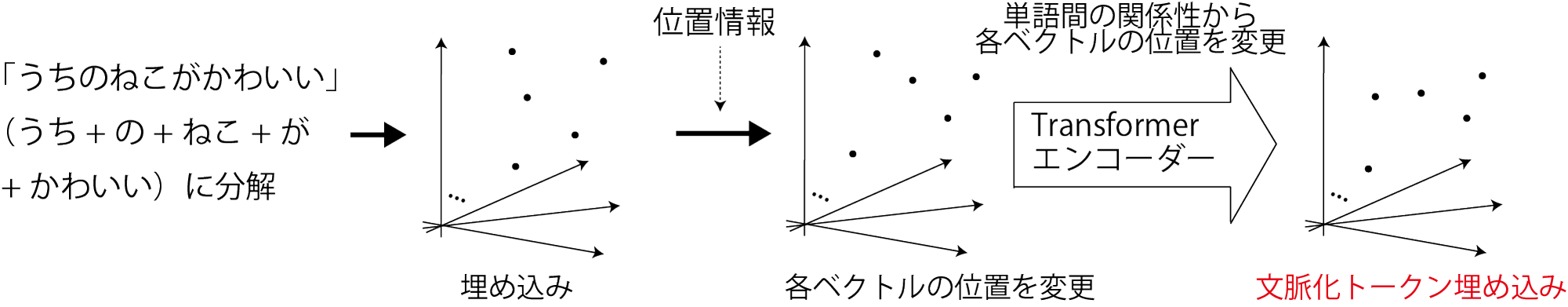

- 埋め込みに語順と文脈の情報を付加してやるとよい

- 前ページのスライドを逆に考えると、そういうことになる

- Transformer(のエンコーダ)

- 入力: 埋め込みに位置情報を加えて変更したもの

- 出力: 文脈化トークン埋め込み

- 各単語の関係性(文脈)に応じて各ベクトルの位置を変更

- 次の単語の予測などにより有用な埋め込み(使い方はあとで)

Transformer

- 翻訳のためにGoogleで開発された

- 正体: 右のような構造のニューラルネットワーク(あとから細かく見ていきます)

- GPT(Generative Pre-trained Transformer)などはこれの応用

- その他言葉を扱うアプリケーションもだいたいこれの応用

- 画像にも応用されている

- ViT(Vision Transformer)

Transformerのエンコーダ: 入力

- 入力: 文

- トークン(単語をより細かく文を区切ったもの)

に分けて、埋め込みのベクトルに変換

- トークン(単語をより細かく文を区切ったもの)

- 文への位置情報の付加(右図Positional Encoding)

- 行列

- 単純に「何番目か」ではなく三角関数を使ったややこしもの

- 行列

Transformerのエンコーダ: 文脈情報の付加1

- 自己注意機構という仕組みで文脈の情報を付加

- 行列

- これらの行列は学習の対象で、ここでは学習が済んでいると仮定

- 3つのベクトルを使う自己注意機構なので特に

「キー・クエリ・バリュー注意機構」と呼ばれる方法(次のスライドに続く)

- 行列

Transformerのエンコーダ: 文脈情報の付加2

- 手順

- 次の

- 手順

Transformerのエンコーダ: 文脈情報の付加3

-

- このあと2層のニューラルネットワークを通ってさらに文脈が強化された文脈化トークン埋め込みに

-

全体で

エンコーダの出力を使った翻訳

- 問題の定式化: 条件付き確率の問題にする

(例: 日本語から英語への翻訳)- 問題1: 先頭のトークンを選ぶ

- 問題2: 2番目のトークンを選ぶ

- 問題3: 3番目のトークンを選ぶ

- 問題1: 先頭のトークンを選ぶ

- Transformerのデコーダがこれを解く

デコーダ側の処理1

- 自己注意機構で翻訳途中の文の文脈を埋め込みに反映

- 途中の文なので計算のときに少し細工が必要だけど、

エンコーダと同じ

- 途中の文なので計算のときに少し細工が必要だけど、

デコーダ側の処理2: 交差注意機構

- もとの言語の文脈を翻訳中の文に持ち込む

- クエリ埋め込み

- キー埋め込み、バリュー埋め込みは、エンコーダ側の出力から計算

- クエリ埋め込み

デコーダ側の処理3: 次の単語の出力

- 全単語について次の単語になる確率を計算して、

その確率が最も高いものを出力- 文脈がしっかり考慮されているので、かつての

マルコフ連鎖ジェネレータのようにはならない - その文脈に最もふさわしい単語が出てくる

- 文脈がしっかり考慮されているので、かつての

Transformerの応用例

GPT(Generative Pre-trained Transformer)

- 途中の文から次の単語を予測

- デコーダだけで構成

- ChatGPTの一部に使われる

ChatGPT

- GPTを使ってテキスト(人の質問や発言)に答える

- (構造に関する決定的な文献なし)

Vision Transformer (ViT)

- Transformerを画像に転用

- 画像をブロック状に切って単語のように扱う(右図)

- 右図のCLS: クラストークン

- 分類のためにくっつけるデータでこれを計算して出力する

- 画像をブロック状に扱うのはCNNと同じだが、そのあとが違う

- CNNは遠くのブロックの関係性を見るのが苦手

Contrastive Language-Image Pre-training (CLIP)

Segment Anything

- コードや説明

- プロンプトの指示で画像から特定の部分を切り出す(セグメンテーション)

- 画像のエンコードにはViTを使う

- プロンプトのエンコードにはCLIPを使う

Stable Diffusion

- プロンプトを画像に変換

- プロンプトから画像のタネを作るためにCLIPを利用

- 画像を復元するときにも注意機構

- 図

まとめ

- Transformer

- 埋め込みに文脈を反映させる仕組み

- 埋め込み

- 次元の高いベクトルで、単語やトークンの様々な関係性を表現可能

- skip-gramなどの学習方法で実用性のある埋め込みが作成可能

- ViTなどでは画像に対しても作られる

- 埋め込みを使うと性質の異なるデータを交差注意機構で関連させることが可能

- ある言語

- 画像

- ある言語