神経細胞を単純化したモデル

- 右図のような構造に簡略化(人工ニューロン)

- 他の

- ひとつの値だけ信号

なら

- 接続先は複数だが同じ値を送信

- 他の

- 他の細胞も同様にモデル化すると

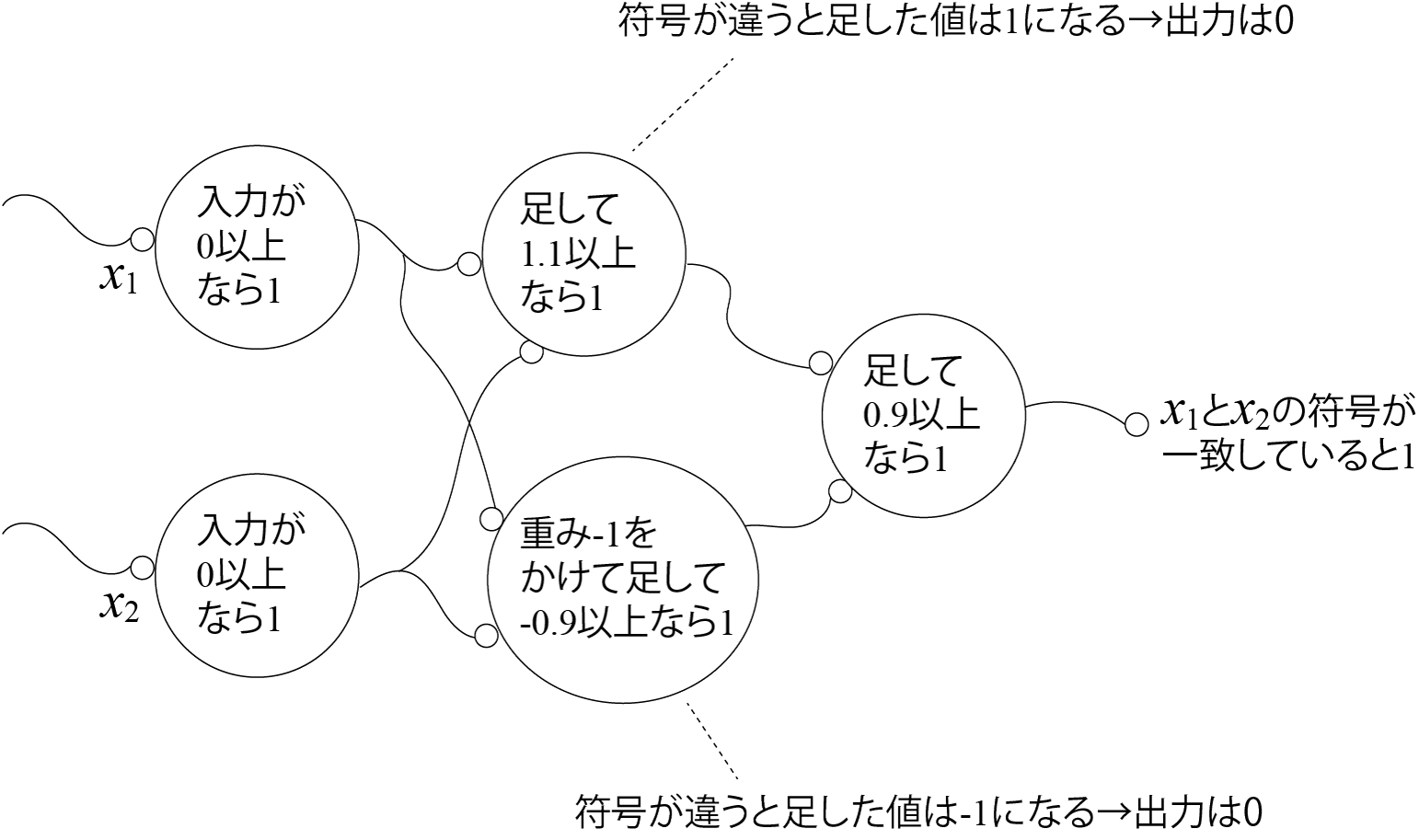

人工ニューロンで回路を組んでみる

- 問題: 2つの数字

- 値が0の場合は正としましょう

- 答え

(人工)ニューラルネットワーク

- 神経細胞は前ページのように組み合わせてプログラムできる

- 人の脳には860億個の神経細胞

- 860億個が組み合わさってさまざまな計算をしているのでいろいろできる

- 目から入った光で猫がいたら「猫!」と叫ぶ(目→脳→口の筋肉)

- 手を動かして目の前のお菓子をとる(目→脳→腕や手の筋肉)

- カレーの匂いがしたらよだれが出る(鼻→脳→よだれを出す器官)

- 講義中にゲームをする(?)

- 860億個が組み合わさってさまざまな計算をしているのでいろいろできる

- コンピュータでも人工ニューロンで計算すれば or 人工ニューロンを実現するようなコンピュータを作れば、脳の計算が可能

人工ニューラルネットワークの正体

- やってることは単なる行列の演算

- 先ほどの例の一番左の「層」

- 入力:

- 重み:

- 上、下のニューロンがそれぞれ

- 上、下のニューロンがそれぞれ

- 出力の計算:

- 入力:

あとは繰り返し

- 1層目(再掲)

- 入力:

- 入力:

- 2層目

- 入力(1層目の出力):

- 入力(1層目の出力):

- 3層目

- 入力(2層目の出力):

- 入力(2層目の出力):

レイヤーでの表現

- 入出力を線でつなぎ、演算を箱で表現

- これまで使ってきた例だと1層分が2層に

- 重みの反映(と閾値の引き算)で1層

- アフィンレイヤー

- 閾値処理で1層

- ステップ関数レイヤー

- 重みの反映(と閾値の引き算)で1層

- 注意: 右の図ではあまり入出力の数が変わってないが、実際はアフィンレイヤーの前後で変わる

残った問題: どう学習するか?

- 動物は生まれたときにある程度プログラミングされた状態だが・・・

- そのあと成長しても神経細胞は基本的に増えない

- 猫を識別するにはニューラルネットワークに変更を加えないといけない

- 頭を開けて配線するわけにはいかない

学習の方法: パラメータを変える

- 例題:

- 最初、パラメータはあてずっぽ(右図上)

- 基本的な方法

- 何か入力して出力と正解の「ずれ」を観測する

- 例えば上のニューロンに

- 例えば上のニューロンに

- ずれを小さくするようにパラメータを変える

- この場合はたとえば

- この場合はたとえば

- 何か入力して出力と正解の「ずれ」を観測する

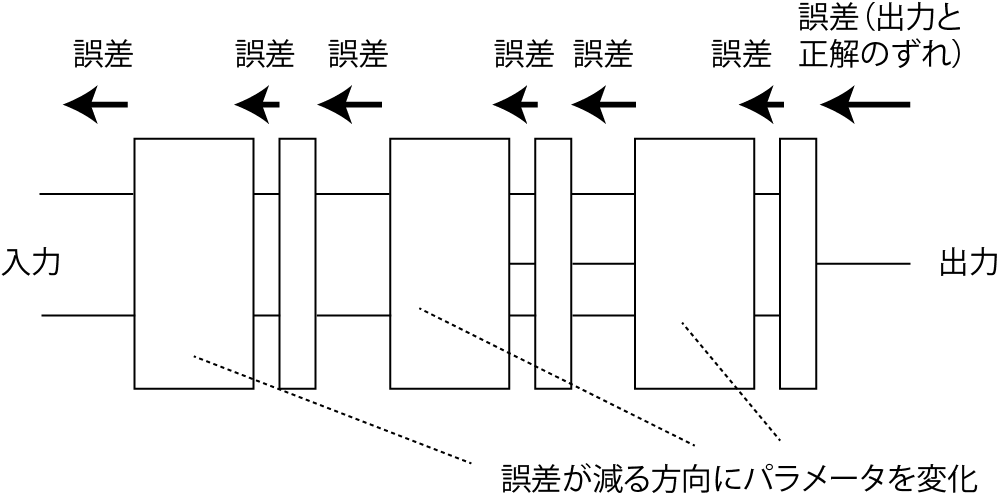

これを全ニューロンに対してやる(以後はレイヤー表記)

パラメータをどう変えるか?

- 案1: 出力を間違えたらあてずっぽで変える

- 案2: ずれが小さくなるようにパラメータを変える

- ちょっと変えたらちょっとでもいいので

誤差が減ってほしい

(どうすればいいか議論してみましょう)

- ちょっと変えたらちょっとでもいいので

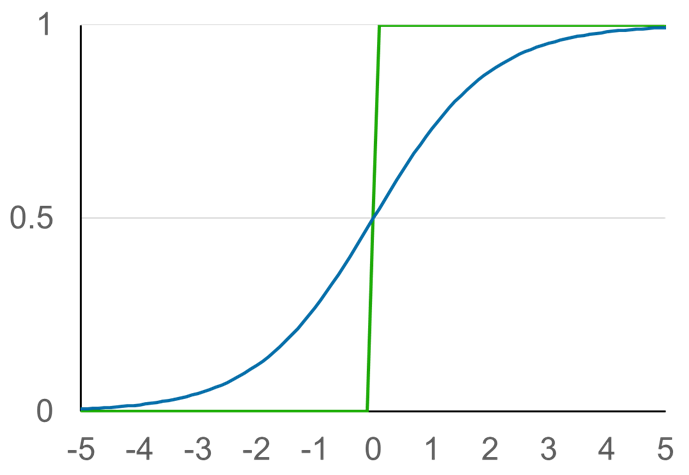

対策

- 方法1: 出力をアナログ値に(次のページ)

- 方法2: たくさん入力して期待値をとる

- バッチ、ミニバッチと呼ばれる方法で方法1と共に使われる

シグモイド関数で微妙にアナログに

- シグモイド関数のグラフ

- 青線

- 緑はこれまでのステップ関数

次なる問題: ずれに対してどれだけパラメータを修正するか

- 誤差逆伝播法

- 出力側の誤差をどんどん入力側に送っていく

- 誤差の大きさは、そのニューロン(層)の影響を考えて加減する

- 誤差の大きさは、そのニューロン(層)の影響を考えて加減する

- 送られてきた誤差が小さくなる方向にパラメータを変える

- 出力側の誤差をどんどん入力側に送っていく

単純な例

- 送る誤差の大きさ

- ある層で誤差が

- 上の層での値の違いが

- 上の層での値の違いが

- 右図上: 1入力1出力の単純なレイヤー

(出力

- ある層で誤差が

- パラメータの修正(計算式の根拠は次ページ)

アフィンレイヤーの誤差逆伝播

- 出力の誤差:

- 最終的な誤差

- 最終的な誤差

- 入力(前の層の出力)の誤差: 同様に

- (行列の計算はさておき)重み

- (行列の計算はさておき)重み

- シグモイドレイヤーも同様に計算すると

アフィンレイヤーのパラメータ修正

- 誤差に対するパラメータの影響

- これらの値を

- 割り引くのはひとつの入力だけでパラメータを大きく変えないため

問題: p. 14のニューラルネットワークのパラメータ修正

- 右図上の状態から右図下の状態にもっていきたい

- 修正のための式(p. 19のもの):

答え

-

計算(再掲)

-

-

次に

答え

-

計算(再掲)

-

-

できる人は前方のニューロンに送る誤差も計算を

まとめ

- 人工ニューラルネットワーク

- ニューロンの組み合わせでプログラムできる

- 誤差逆伝播で学習ができる

- 次回、次々回で応用を見ていきましょう