混合ガウス分布のベイズ推定

- 「混合分布の分布」を考える

- 右図のように分布をドローできるもの

- EM法との違い

- 最尤なものでなく、分布の分布自体を計算

- データが入ると分布をベイズの定理で更新

- 問題: 事後確率がベイズの定理一発で計算できない

- どうするか?

- どうするか?

推定対象(混合ガウス分布)のパラメータ

「分布の分布」ではなく「分布」のほうの話

- 各ガウス分布のパラメータ:

- (おさらい)混合ガウス分布:

(

- (おさらい)混合ガウス分布:

- 各データ

- どのガウス分布に所属しているか

- 潜在変数

変分推論による解法

- 推定対象の分布を、パラメータごとに独立な分布の積にして近似

EM法と同じ(だけど計算はよりややこしく)

- 次ページから

(

(添字- これは特定の式にせずにテーブル状のデータに

- 各データに対する

- ディリクレ分布を仮定

- ベータ分布をコインの裏表だけでなく多変数に拡張したもの

- 例: さいころなら6

パラメータ

- ベータ分布をコインの裏表だけでなく多変数に拡張したもの

- 各ガウス分布

ガウス-ウィシャート分布- ウィシャート分布

- 各ガウス分布の分布を決めるパラメータ:

- ウィシャート分布

- 各ガウス分布ごとの

これまでの変数、パラメータ一覧表

| データ | 推定したい分布のパラメータ | 推定したい分布の分布のパラメータ |

|---|---|---|

変分推論の手続き

- 適当に

- 確率

- パラメータ

- 確率

- EM法のMステップに相当(変分Mステップ)

- EM法のEステップに相当(変分Eステップ)

- 注意:

- 事前分布を固定して、繰り返し事後分布の解を良くしていく

変分推論の威力(その1)

とても強力なので具体的な計算方法の前に例を見せます

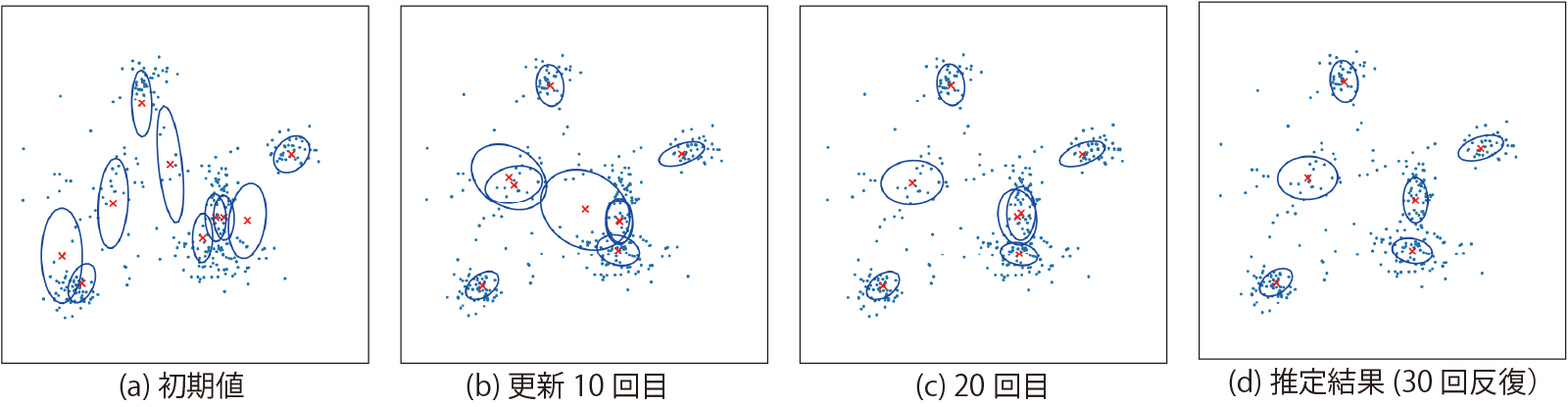

- 例1: 2次元の点のクラスタリング

- 右図: 6個のガウス分布を含む混合ガウス分布からランダムに選んだ点

- このデータのクラスタリング(というより発生した混合ガウス分布の推論)に変分推論を適用するとどうなるか

推論の推移

- 混合ガウス分布の分布から平均値となる分布を描画

- 10の分布があることを仮定

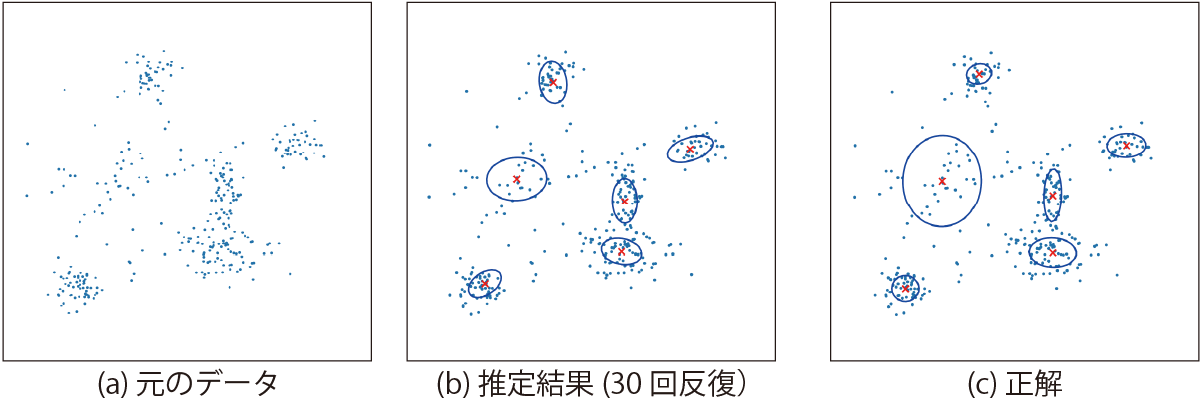

正解との比較

- 共分散行列のずれは多少あるが、正確

- 人間より正確かもしれない

- (上限があるものの)数が数えられるのはかなり有用

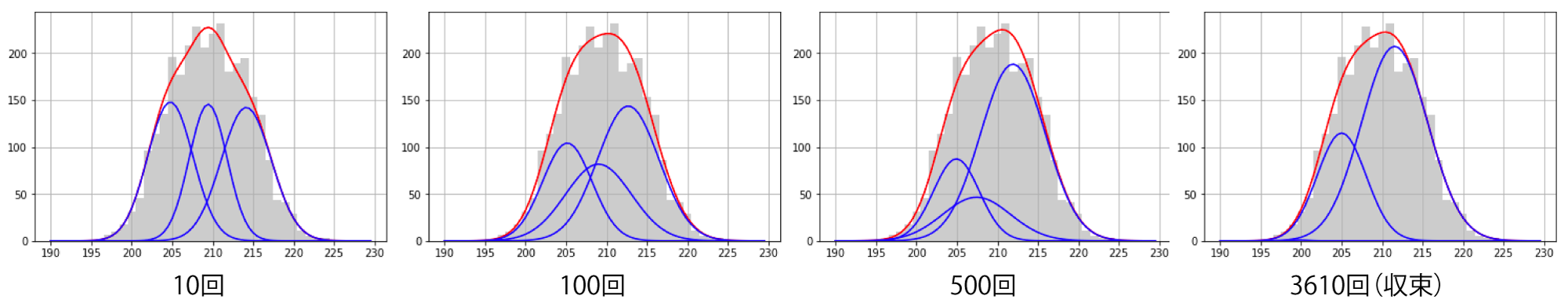

変分推論の威力(その2)

- 例2: 1次元のデータの解析

- 講師が本を書いていて偶然発見

- 右の分布はガウス分布か?

変分推論してみると・・・

- もうひとつの分布が埋まっていた

- このデータは、あるセンサの値を3秒ごとにとったもので、日が出ているときと出ていないときで平均値が違っていた

- ある意味、人間よりもクラスタリングの解像度が高い

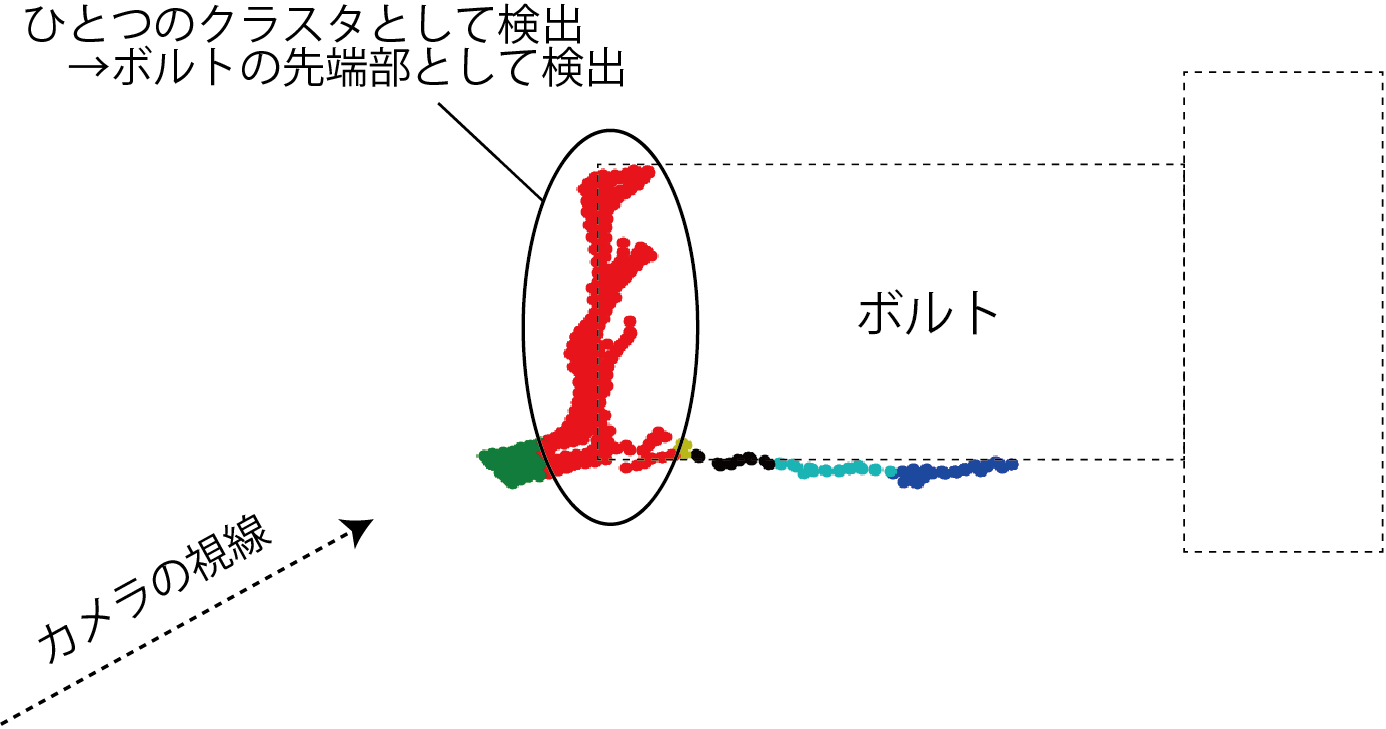

実世界での使用例1

- ボルトの先端の検出

- 3次元の位置を1次元に変換してからクラスタリング

実世界での使用例2

- 物体表面の把持位置の

クラスタリング- 法線ベクトルの位置、向きの6次元空間

変分推論の具体的な計算

- 導出は難しすぎるので、MステップとEステップでの作業だけ示します

- 導出された式に当てはめるだけで使用可能

変分Mステップ(各データの所属から分布のパラメータを計算)

- 補助の数値を計算

- 事後分布のパラメータを計算

(各ガウス分布の共分散行列の調整)

変分Eステップ(分布のパラメータから各データの所属を計算)

- 計算結果: 次の

- 式中の変数はすべて一時的に値が決まっているか既知なので計算可能

まとめ

- 変分推論

- 混合分布の分布を考える

- EM法とおなじく繰り返しでクラスタを形成していく

- 計算方法が(扱わなかったけど)ベイズの定理に基づいている

- 強力