Vision Transformer(ViT)[Dosovitskiy 2020]

- Transformerのエンコーダを画像に転用

- 画像をブロック状に切って単語のように扱う(右図)

- 右図のCLS: クラストークン

- 文の分類と同じ

- 全結合層(MLP Head)に通す

- 画像をブロック状に扱うのはCNNと同じだが、CNNは遠くのブロックの関係性を見るのが苦手

画像: CC-BY-4.0 by Daniel Voigt Godoy([Dosovitskiy 2020]のFig.1にも構成図)

ViTの大きさ

- オリジナルの論文には大きさの異なる複数のモデル

- ViT-Base: 層の数12、ベクトルの次元: 768、パラメータ数: 8600万

- ViT-Large: 層の数24、ベクトルの次元: 1024、パラメータ数: 3.07億

- ViT-Huge: 層の数32、ベクトルの次元: 1280、パラメータ数: 6.32億

トークンに対応するベクトルの作り方

- 画像を

- 例:

- 3はチャンネルの数(RGB)

- 位置の埋め込みも行う

- ただし固定値ではなく、パラメータは学習対象

- 例:

- 画像の理解

- 局所的な理解: ベクトルの中

- 大域的な理解: 自己注意機構で学習

事前学習の方法

- 教師あり学習で分類問題を解く

- 言語と違って教師なし(BERTのような穴埋め)はあまり効果がない

- オリジナルの論文で用いられた訓練データ

- JFT-300M

- 3億枚の画像、18291クラスのデータセット

- ImageNet-21k

- 1400万枚の画像、21841クラスのデータセット

- JFT-300M

- 訓練データが多いと高い性能を発揮(JFT-300Mのほうがよかった)

ViTの機能のしかた

- 位置の埋め込みに関して

- [Dosovitskiy 2020]のFig. 7左

- 画像処理で使われる基底関数のようなものができている

- どこを見て判断しているか

- [Dosovitskiy 2020]のFig. 6、Fig. 7右

- 自己注意機構のヘッド(マルチヘッド注意機構のヘッド)には、入力に近い層ですでに大域的なものとローカルなものなどバリエーションが出る

- 大域的なものはCNNの入力に近い方のたたみ込み層に類似

- 入力から遠ざかるとより大域的に

Image GPT[Chen 2020](サイト)(動画)

- GPTの画像版

- GPT-2の構造を使用

- パラメータ数: iGPT-Lというモデルで

- 画像を途中まで入力して、次の画素を当てさせる

- PixelCNNと同じ問題

- GPT同様、ヘッドをつけてファインチューニングすると他のタスクに利用可能

Image GPTの学習

- 2種類の訓練方法

- 次の画素の予測(GPT的)

- 穴埋め問題(BERT的)

- 埋め込みに相当するベクトル: 画像の解像度を下げて1列に並べたもの

- サイト:

- 論文:

- サイト:

Diffusion Transformer(DiT)[Peebles 2022]

- 拡散モデル+Transformer

- さらに潜在空間に情報を圧縮する潜在拡散モデルも使用

- ラベルを入力して出力をコントロール(分類器なしガイダンス)

- 構造

- [Peebles 2022]の図3

- 入力: 画像のトークンの他、ラベルを表すベクトルと時刻を表すベクトルを足したトークン1つ

- 後者はadaLN-Zeroという仕組みで画像に作用させる

- FiLMにもうひとつパラメータを足したようなもの

- 後者はadaLN-Zeroという仕組みで画像に作用させる

- 出力: 画素ごとのノイズの平均値と分散

- 入力: 画像のトークンの他、ラベルを表すベクトルと時刻を表すベクトルを足したトークン1つ

- 画像のサイズを落とすためにVAEを使用

- [Peebles 2022]の図3

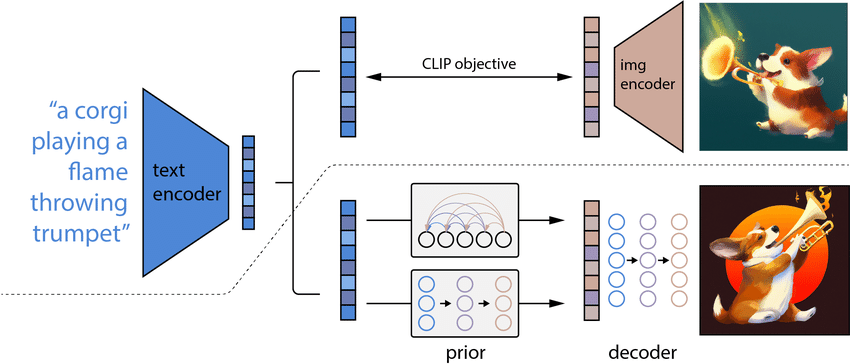

CLIP(Contrastive Language-Image Pre-training)[Radford 2021]

- contrastive: 「対照的な」という意味

- 対照学習(あとで説明)でテキストと画像を結びつけ

- 図

- CLIPでできること

- 画像に何が写っているかを認識(ある意味ではラベルの数に制限がない)

- テキストから画像を生成するときの部品

- unCLIP(あとで扱います)

CLIPに関する背景

- よく行われてきた画像認識の方法の手順

- 写真をあつめる

- 写真に写っているものをラベル付けする

- 学習

- 上記方法の問題

- めんどくさい

- ラベルのあるものしか認識できない

ラベル(ではなくキャプション)のついた画像の収集

- 画像にはキャプションのついたものがある(論文はそうですよね?)

- 原論文: 4億組の画像とキャプションのセットを収集

- 問題: キャプションは単語ではなく文や句になっている

- 単純なラベルではない

CLIPの学習方法

- 前ページの方法で学習用のデータを準備

- ViTを使って画像をエンコーディング

- Transformerを使って文をエンコーディング

- エンコーディングされたデータ(埋め込み)同士の相関を学習

- 補足: 必ずしもViT、Transformerである必要はない(が、Transformerを使ったほうが性能が高くなる)

CLIPの構造

- p.12の図

- image encoder: ViT

- 入力は画像

- クラストークンを出力として使う(数百次元のベクトル)

- text encoder: Transformerのデコーダから交差注意機構を除いたもの

- 入力は画像のキャプション

- 出力のフォーマットをimage encoderの出力に合わせる

- 数理的に重要な点: マルチモーダルであること

- text encoderとimage encoderの出力が同じ潜在空間にプロットされる

- キャプション(文、句)と画像が同じ空間に配置され、似たものが近くに配置される

- text encoderとimage encoderの出力が同じ潜在空間にプロットされる

評価方法(対照学習、contrastive learning)

- image encoderの出力: ベクトル

- text encoderの出力: ベクトル

- image encoderの出力: ベクトル

- ペアとなっている画像とキャプションのベクトルを同じにしたい

- コサイン類似度:

- コサイン類似度:

- ペアでない画像とキャプションのベクトルを違うものにしたい

学習したモデルの使い方

- 例: 画像の分類

- 分類したいものに対してラベルを

- 「a photo of <ラベル>」という句を

- 画像をimage encoderに通して特徴ベクトル

- 分類したいものに対してラベルを

DALL·E(ダリ)[Ramesh 2021]

- 句や文から画像を生成

- Transformerに、文章の続きとして画像を考えさせる

- 使うもの

- Transformer(デコーダ)

- GPT-3の改造版

- 画像も埋め込みベクトルにして入力できるように

- VQ-VAE(論文ではdiscrete VAE(dVAE)といっている)

- Transformer(デコーダ)

DALL·Eの学習

- キャプションと画像がペアになったものを訓練データに

- CLIPと同じ

- Stage 1: 集めてきた画像を使ってdVAEに学習させる

- 学習済みのデコーダに符号列を入力すると画像が生成されるように

- Stage 2: 入力文の後ろに符号列を生成するようにTransformerを学習

DALL·Eによる画像の生成

- 前ページステージ2の構成で

- https://openai.com/ja-JP/index/dall-e/ のサイト

- 512枚の画像を生成して、CLIPでランク付けして上位32枚を出力

- 遊んでみましょう

- https://openai.com/ja-JP/index/dall-e/ のサイト

GLIDE[Nichol 2021]

- Guided Language to Image Diffusion for generation and Editingの頭文字

- generationがかわいそう

- 「言語で誘導された画像の生成、編集のための拡散モデル」

- 自然言語+分類器なしガイダンスで拡散モデルに画像を生成させる

- (他、「CLIPガイダンス」も試されたが分類器なしのほうが結果がよかった)

- 自然言語をエンコードしたものを分類器なしガイダンスのラベルに利用

- 構造はU-Net

- 生成される画像: 論文の図1

- ファインチューニングで画像の一部をテキストで改変できる(image inpainting): 論文の図2, 3, 4

DALL·E 2(公式の動画)

- DALL·Eの後継

- 基本的なアイデア

- CLIPを使う

- テキストと画像が同じ潜在空間にいるので、

潜在空間のベクトル- ただし、整った画像を出力するためにいろいろ工夫

構造

- 点線の上: CLIP(学習のときに使う)

- 点線の下: 生成の部分

- 事前モデル(prior)とデコーダ(ほぼGLIDE)で構成

事前モデル+デコーダ(unCLIP[Ramesh 2022])

- テキスト

- 数式上は冗長だが学習のときにヒントが増えて質が向上

- 最後の項:

- 後ろの確率分布: 事前モデル

- 質の高い画像の特徴ベクトルを出力

- 単にテキストの特徴ベクトルを出力するのではなく、テキストも入力して強化

- 前の確率分布: デコーダ

- こちらもテキストを再度入力

- 後ろの確率分布: 事前モデル

Stable Diffusion

- サービスのサイト: https://stablediffusionweb.com/ja

- DALL·Eシリーズのライバル

- 使いやすくて一気に普及

- 50億枚の画像を訓練に使用

Stable Diffusion(v1)の構造(Latent Diffusion Models、LDM)[Rombach 2021]

- [Rombach 2021]の図3(Wikipediaに掲載されている図)

- 上部の

- 訓練画像を潜在空間のベクトルに変換してからDDPMで拡散

- 潜在空間: [Esser 2020]で提案されたVQGANのもの

- 要はVQ-VAEのGAN版

- 図中のピンク色の部分がVQGAN(の変種)

- 潜在空間: [Esser 2020]で提案されたVQGANのもの

- 訓練画像を潜在空間のベクトルに変換してからDDPMで拡散

- 下部の

- ノイズを潜在空間のベクトル

- テキストや画像の埋め込み(図の白枠内で生成)によるガイダンスを交差注意機構で行う

- 基本、行列の計算なのでU-Net内にも組み込める

- ノイズを潜在空間のベクトル

- 上部の

まとめ

- 言語処理の技術の画像への転用や画像処理との組み合わせを勉強

- この間にもどんどん最新のサービスがリリースされている

- 新しい技術も開発されている

- 扱っていないもの: 動画の理解や動画の生成