パラメータをどう変えるか?

- 案1: 出力を間違えたらあてずっぽで変える

- 案2: ずれが小さくなるようにパラメータを変える

- ニューロンはたくさんある

- どうやって??

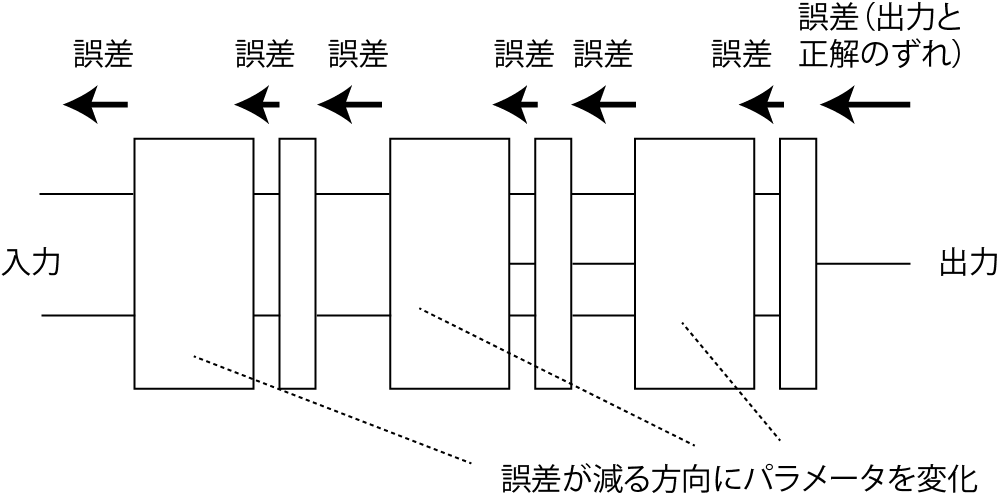

誤差逆伝播法

- 出力側の誤差(損失関数の値)をどんどん入力側に送っていく

- 値の大きさは、そのニューロン(層)の影響を考えて加減する

- 「影響を考えて」

- 例: ある層が入力を2倍して出力

- 例: ある層が入力を2倍して出力

- 「影響を考えて」

- 値の大きさは、そのニューロン(層)の影響を考えて加減する

- その後: 送られてきた誤差が一定の割合で小さくなる方向にパラメータを変更

単純な例

- 右図上: 1入力1出力の単純なレイヤー

(出力

- 理屈: 偏微分(

質問: じゃあアフィンレイヤーはどうなる?

アフィン層の場合

- 出力側の損失関数の増大率:

- 入力側の損失関数の誤差の拡大率:

- 偏微分の連鎖律

- 重み

誤差逆伝播法のまとめ

- (層の種類によらず)上流の層はどこでも連鎖律を利用して誤差を計算可能

- ただし微分できることが必要

- ある層の誤差は下流の層から伝わってきた誤差に基づいて計算可能

- 各層は、自身の偏微分の式だけで誤差を計算可能

- シグモイド関数

- 各要素の具体的な値:

パラメータの修正

- 下流から伝わってきた誤差を小さくするように更新

- ひとつのパラメータの更新式

- 単純な例(右図。

アフィンレイヤーのパラメータ修正

- 誤差に対するパラメータの影響

- なんで偏微分の順序が変わるか

(講師は未検証です。すみません!)

- なんで偏微分の順序が変わるか

- 更新式(どんなレイヤーでも共通)

問題: p. 14のニューラルネットワークのパラメータ修正

- 右図上の状態から右図下の状態にもっていきたい

- 修正のための式(p. 11のもの):

答え

-

計算(再掲)

-

-

次に

答え

-

計算(再掲)

-

-

できる人は前方のニューロンに送る誤差も計算を

補足: スキップ(残差)接続

- あるレイヤーの出力を次の層だけでなく、

別の層にも入力する接続方法- 入力に挟まれた層は入出力の差分を

学習することに

- 入力に挟まれた層は入出力の差分を

- スキップ接続の有無: 初期の学習の容易さに影響

- スキップ接続なし: 最初は

- スキップ接続あり: (途中の層の出力が最初ゼロだと)最初は

- スキップ接続なし: 最初は

- ResNet(2015年)

まとめ

- 人工ニューラルネットワーク

- ニューロンの組み合わせでプログラムできる

- 誤差逆伝播で学習ができる

- 以後の講義で応用を見ていきましょう